정의

“공간 컴퓨팅”이라는 단어는 가상현실 분야가 상용화되기 시작하던 1990년대 초반부터 간간이 사용되었다고 알려져 있으나, 2003년 MIT Media Lab의 연구원 시몬 그린월드(Simon Greenwold)가 해당 주제로 석사 학위 논문을 작성하며 학계에 정식으로 등장하였다. 그는 공간 컴퓨팅을 ‘실제 물체와 공간에 대한 참조를 유지하고 조작하는 기계와 인간의 상호 작용’이라고 정의했다(Greenwold, 2003). 이를 풀어서 설명해본다면 사용자가 본인을 둘러싼 실제 공간에 직접 가상 요소를 만들어 곧바로 추가할 수 있는 시스템을 일컫는다고 해석할 수 있다. 저자는 공간 컴퓨팅이 다루는 공간과 가상 요소의 형태가 반드시 실제적인 가치를 기반으로 해야 한다는 점에서 모든 요소가 디지털로 이루어지는 3D 모델링 혹은 디지털 디자인과 차이를 두었다. 또한 사용자의 손, 음성, 신체 움직임을 활용해 자연스럽고도 직관적으로 실제 세계와 상호작용이 가능해야 함을 강조하였다. 즉, 공간컴퓨팅은 실존하는 현실 세계를 바탕으로 디지털 콘텐츠를 현실 공간과 결합하는 기술이라고 볼 수 있다.

구현 기술

공간 컴퓨팅의 핵심은 이동통신망이 뒷받침된 상태에서 핵심 기술인 XR(확장 현실), AI(인공지능), IoT(사물인터넷)를 중심으로 가상 경험을 물리적 세계에 혼합하는 것이다. 먼저, 공간 컴퓨팅은 2020년부터 시작된 5G, 그리고 그 이후로 다가올 6G 이상의 이동통신망을 전제로 한다. 5G에 이르기까지 전세계 공통의 범용 기기는 데이터를 통해 멀티미디어를 구현하는 게 중심인 스마트폰이었다. 그동안 이동통신망의 발전은 거듭되면서 더 빨라지는 속도 속에서 IoT의 사용까지 가능해지게 되었다. 이때 MR 헤드셋과 같은 XR기기가 등장하면서 사용자는 눈, 손, 목소리 등을 포함한 포괄적이고도 몰입감 높은 소통을 할 수 있게 되었다. 여기서 햅틱 글로브, 트레드밀과 같은 IoT가 인간이 느낄 수 있는 감각의 영역을 확장하여 XR 기기로의 몰입감을 향상시키는 데 도움을 준다. 스마트폰에서는 이어폰, 스크린, 카메라 등 다양한 기능이 한 곳에 모였던 것이었다면, XR 기기에서는 연결성을 바탕으로 이어폰은 귀에, 스크린은 눈에, 촉각은 손에 연결되듯 기기가 제공하는 기능들이 감각 기관으로 분산, 연결되는 양상을 보이는 것이다(신동형, 2023). 더불어 XR과 IoT의 하드웨어와 소프트웨어적 제약 때문에 부족한 부분을 알고리즘으로 보완해 주는 AI 역시 중요한 보완 기술이 될 전망이다. 이처럼 공간 컴퓨팅은 기존 컴퓨터가 지닌 단면 스크린의 경계를 뛰어넘어 인간과 컴퓨터 사이의 새로운 관계를 형성한다. 이 밖에 공간 컴퓨팅을 구현하는 주요 기술들로 거론되는 항목들은 다음과 같다:

•

Computer vision(컴퓨터 비전): 소프트웨어가 이미지의 픽셀을 읽는 것 대신 이미지의 내용(인간에게 의미하는 바)을 이해할 수 있도록 만드는 경우

•

Sensor fusion(센서 융합): 기계가 카메라 또는 GPS와 같은 여러 센서의 감각 데이터를 결합하는 경우

•

Spatial mapping(공간 매핑): 기계가 카메라나 센서에 포착된 데이터를 사용하여 영역의 3D 지도를 작성하는 경우

•

Haptic feedback systems(햅틱 피드백 시스템): 장치가 전화가 왔을 때 진동하는 것과 같은 촉각적인 경험으로 인간과 통신하는 경우

•

Machine learning(머신 러닝): 시스템이 공간 데이터를 수집하고 분석하여 패턴을 찾고 프로세스를 자동화하는 경우

•

Edge computing(에지 컴퓨팅): 데이터를 중앙 데이터 처리 센터로 전송하는 대신 사용되는 위치(네트워크의 "가장 자리")에 물리적으로 가깝게 처리할 경우

•

Robotics(로봇공학): 로봇이 공간 데이터를 이용해 이동하며 업무를 수행하고, '대리' 로봇으로 원격 작업까지 강화하는 경우

•

IoT(사물인터넷): 물리적 장치 네트워크가 물리적 환경을 이해하고 인간의 경험을 향상시키기 위해 공간 데이터를 사용하는 경우

작동 방식

공간 컴퓨팅의 기술적인 작동 방식은 현실에서 우리가 사람, 동물, 사물 및 목표와 상호 작용하는 방식을 그대로 반영한다. 일반적으로 인간은 눈에서 2D 이미지를 3D 모델의 세계로 번역하고, 세계의 사물을 이해한 다음, 머리에서 지시하는 행동을 몸으로 표현한다. 예를 들어 우리가 컵에 물을 따른다고 가정하면, 물을 따를 때 컵을 본 뒤 컵이 가득 찰 때를 판단한 다음 컵이 가득 찰 때 멈추는 식인 것. 공간 컴퓨팅은 크게 다음과 같은 3가지 단계를 따른다:

[ 단계] 현실 세계를 3D 모델로 이미지 생성

단계] 현실 세계를 3D 모델로 이미지 생성

공간 컴퓨팅을 수행하는 기계에 내장된 Photogrammetry(사진측정학)*, Lidar(라이다)**, Radar(레이더) 등의 기술은 현실 세계를 3D 모델로써 포착한다. 라이다나 레이더는 스캔하는 기기 주변의 물체에서 레이저나 전파 신호의 반사를 측정해 각 지점까지의 거리를 나타내는 포인트 클라우드를 자동으로 인식함으로써 3D 모델을 포착한다. 이어 사진에서 3D 모델을 만드는 기술인 사진 측정학을 통해 여러 이미지 또는 카메라의 이미지가 결합된다. NeRF***와 같은 새로운 AI 기술은 소수의 이미지를 사용하여 더 풍부한 표현을 캡처할 수 있도록 도움을 준다.

*photogrammetry: 측정하고자하는 대상을 사진영상으로 기록하여 이것을 매체로 정량적 또는 정성적인 측정을 하는 과학.

**lidar: 레이저 펄스를 발사하고, 그 빛이 주위의 대상 물체에서 반사되어 돌아오는 것을 받아 물체까지의 거리 등을 측정함으로써 주변의 모습을 정밀하게 그려내는 장치. 대상 물체까지의 거리 뿐 아니라 움직이는 속도와 방향, 온도, 주변의 대기 물질 분석 및 농도 측정 등에 쓰인다.

***NeRF(Neural radiance Fields): 2D 이미지를 3D로 변환해주는 모델. (지난 기사 확인하기)

[ 단계] 이미지 이해를 위한 데이터 분석

단계] 이미지 이해를 위한 데이터 분석

1단계에서 수집된 데이터를 바탕으로 머신 비전과 같은 기술들은 이미지를 이해하기 위해 데이터를 분석한다. 이때 인공지능 기술은 주어진 상황에서 사용자의 행동 패턴을 이해한 뒤 개별 물체를 식별해 정보를 수집하는 것과 같이 수많은 측면에서 중심 기술을 보조하는 역할을 수행한다.

[ 단계] 분석한 데이터에 대한 반응

단계] 분석한 데이터에 대한 반응

2단계에 이은 마지막 단계는 기계가 분석된 데이터에 대해 반응을 보이는 것이다. 자율주행차를 예로 들자면, 3단계는 자율주행차가 앞에 있는 보행자를 감지하고 실시간으로 차량을 멈추기로 결정하는 단계이다. 이처럼 공간 컴퓨팅은 수집된 디지털 3D 이미지를 바탕으로 가상 콘텐츠를 현실과 자연스럽게 연결하여 사용자에게 몰입감과 편리함을 제공해줄 수 있다.

공간 컴퓨팅의 미래

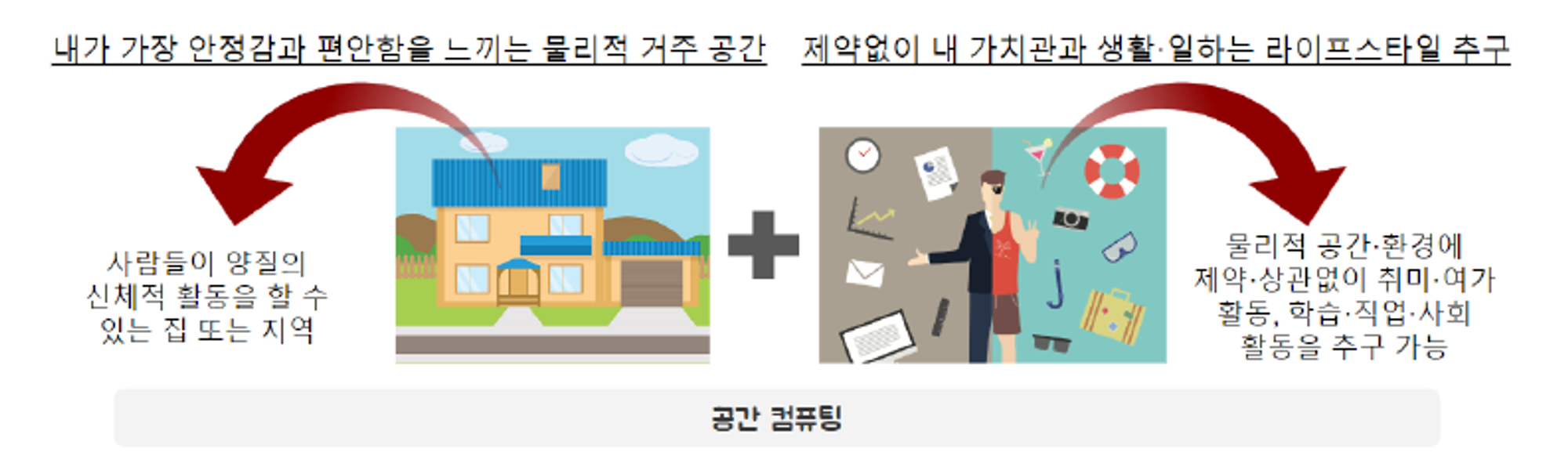

앞서 살펴본 다양한 기술들이 종합적으로 구현되는 공간 컴퓨팅은 우리의 일상에 어떤 변화를 가져올까? 먼저 물리적-디지털 공간이 하나가 되면 가장 먼저 공간의 확장을 가져와 이를 통해 단절된 공간들 속에서 불가능했던 다양한 기회들의 확장까지 가능하게 할 것이다(신동형, 2023). 기술이 아무리 발전해도 달라지지 않는 몇 가지 사실들이 있다. 우리가 밥을 먹고, 옷을 입고, 잠에 드는 일과 같이 일상생활 영위에 필수적이면서 현실에서 벌어져야 하는 일들은 디지털로 온전히 대체될 수 없기 때문이다. 그런데 물리적 공간과 환경에 제약 없이 내가 원하는 대로 자유롭게 활동할 수 있는 디지털 공간이 있다면 어떨까? 공간 컴퓨팅을 낙관적으로 보고 있는 전문가들은 이처럼 현실 공간과 가상 공간의 적절한 융합이 인류가 살아가는 일상의 방향성이 될 것이라고 예측하고 있다.

[출처] NCS 「Digital Insight 2023」

이러한 공간의 확장은 물리적 시공간 때문에 불가능했던 일들을 실현시켜줄 수 있을 것이다. 위와 같이 디지털 트윈의 자동화가 이루어지는 동안 공간 컴퓨팅의 발전은 XR의 고도화를 필연적으로 수반하게 된다. 사용자의 일부가 되어 사용자를 디지털과 하나로 연결해주는 것이 XR 기기이기 때문이다.

핵심 사례: Apple Vision Pro

[출처] Apple

2023년 6월 5일 애플이 WWDC 2023에서 선보였던 혼합현실(MR) 헤드셋 “Apple Vision Pro”가 2024년 2월 2일에 출시되었다. 애플은 이번 신제품을 ‘최초의 혁신적인 공간 컴퓨터’라고 홍보하면서 대중에게 생소한 “공간 컴퓨팅(spatial computing)”이라는 용어를 사용한 바 있다.

Vision Pro는 2개의 디스플레이를 합쳐서 2300만 픽셀을 밀집시킨 초고해상도 디스플레이 시스템이다. VisionOS는 3D 인터페이스를 제공한다는 가장 큰 특징으로 앱이 화면의 제약에서 벗어나도록 하여 사용자가 원하는 크기대로 앱을 나란히 배열할 수 있게 해준다. 이로써 사용자는 무한한 스크린용 공간에서 기존 iOS 앱을 그대로 사용하며 멀티태스킹을 할 수 있는 방식을 통해 일의 생산성 향상을 기대할 수 있다. 이는 컨트롤러 없이 사용자 본인의 눈, 손, 음성만으로 인터페이스를 동작시킬 수 있는 새로운 입력 체계를 통해 사용 가능하다. 또한 애플 기기 중 최초로 3D 카메라를 탑재하여 공간 음향이 내재된 사진과 동영상을 직접 촬영할 수 있다는 점도 두드러지는 특징이다.

2024년 2월 2일 기준 현시점 Apple Vision Pro의 가격은 256GB 저장 용량 기준 3499달러(한화 약 460만원)에 달한다. 경쟁작으로 불리는 메타의 신제품 Meta Quest 3과 비교했을 때 128GB 모델 기준 499달러(69만원), 512GB 모델 기준 649달러(89만원)이므로 어느 쪽으로 보건 5배가 넘는 상황이다. 이는 대중화를 겨냥한 메타에 반해 고급화 전략을 취한 애플의 전략으로 볼 수 있다. 다만 높게 책정된 가격을 두고 ‘과연 기기가 제 값을 할 것인가’에 대해 대중의 의견이 분분한 가운데, 본격 출시 이후 업계의 동향에 관심이 집중될 전망이다.

1.

Simon Greenwold. (2003). “Spatial Computing.” Massachusetts Institute of Technology.

2.

신동형. (2023). “공간 컴퓨팅(Spatial Computing)이 가져올 세상 변화.” NIA 「Digital Insight 2023」. 한국지능정보사회진흥원(NIA).